Сама, Дядя, память и будущее. 🌌

Что может быть общего между Дядей и Самой в ушедшем 2025ом – Память в GenAI, как одна из важных фичей персонализации.

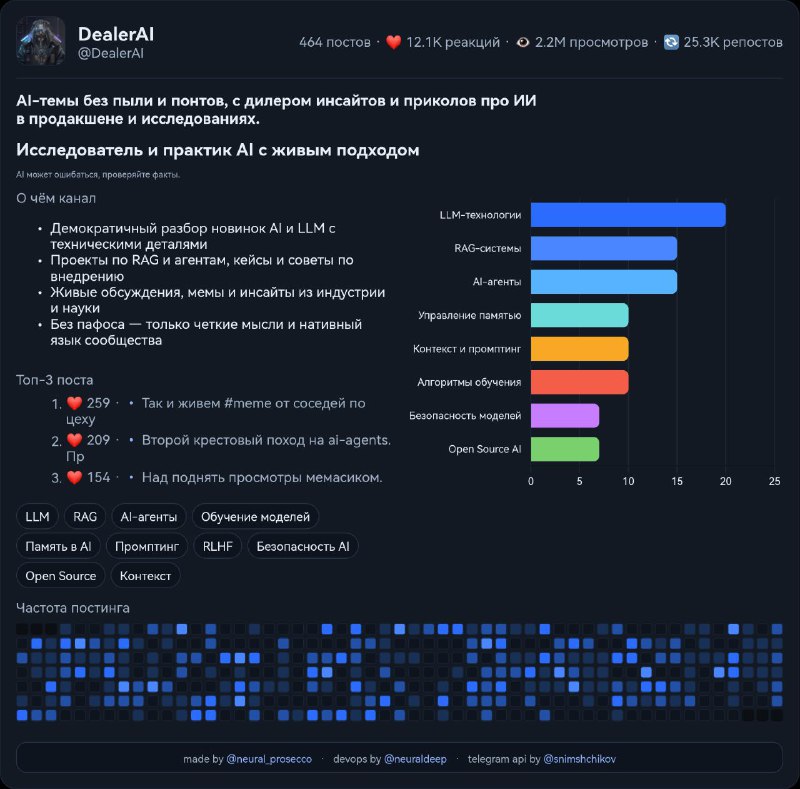

В том году, кажется, Дядя был единственным энтузиастом и адептом памяти для LLM в ру-комьюнити. 💅

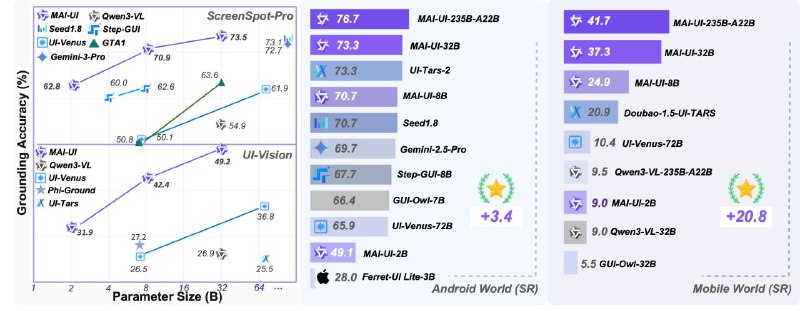

До кучи, одна из моих команд работали над этим больше года и на AIJ 2025 можно было даже увидеть: соревнование и стенд, на котором была эта фича. В дополнении, разумеется, куча постов про system design memory в моем канале, как ни в каком ином. Значит, и этот год стоит начать с этого.

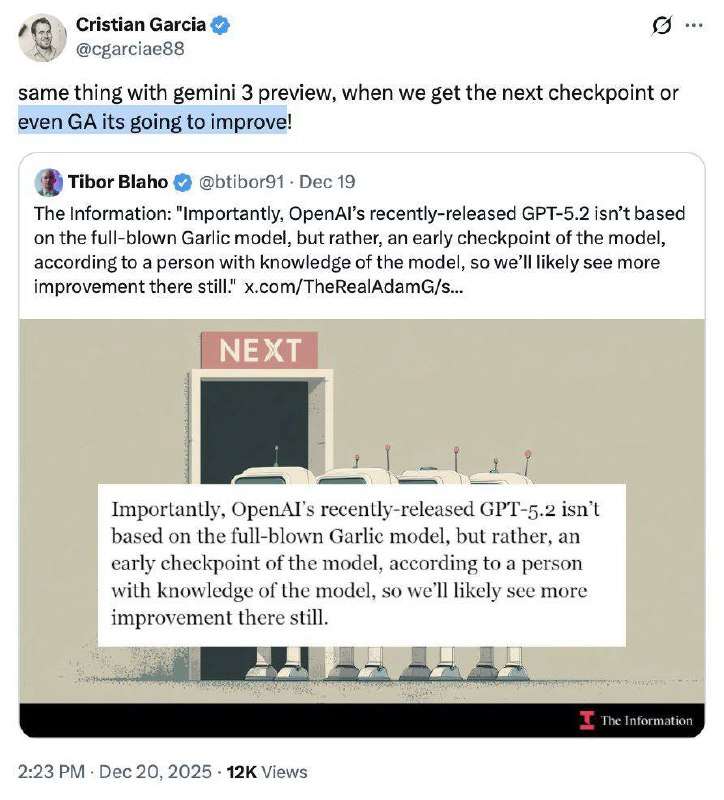

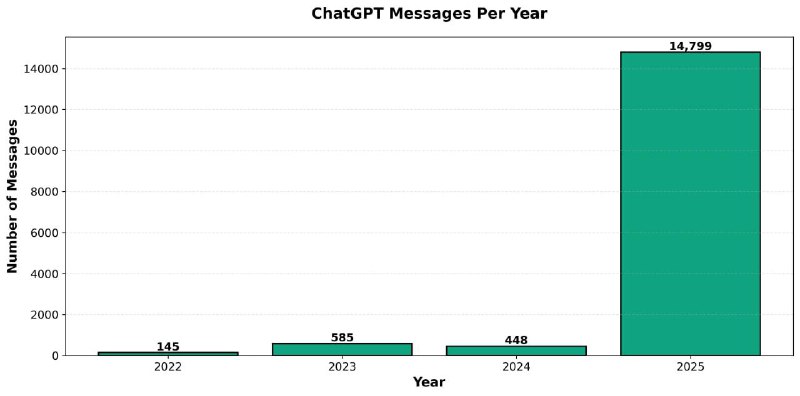

Из последнего -18.12.2025 вышло ещё одно интервью Альтмана, где он также как и я, говорит, что «Memory Makes AI Sticky», жирные намёки на развитие фичи в 2026ом. Конкретно там указывается, что в GPT-6, а я надеюсь появится она в 2026-ом, все будет максимально персонализрованно. Модели не просто будут помнить факты, они будут запоминать все полезное о Вас. Далее цитата: «Будущий ChatGPT будет обладать «идеальной, бесконечной памятью», в отличие от людских помощников. Он будет помнить каждое ваше слово, написанный вами документ и скрытые предпочтения, которые вы никогда явно не формулировали. Текущая память хранит базовые факты; версии 2026 года будут персонализировать, используя всю историю вашей жизни».

Мнение от Дяди. 📦

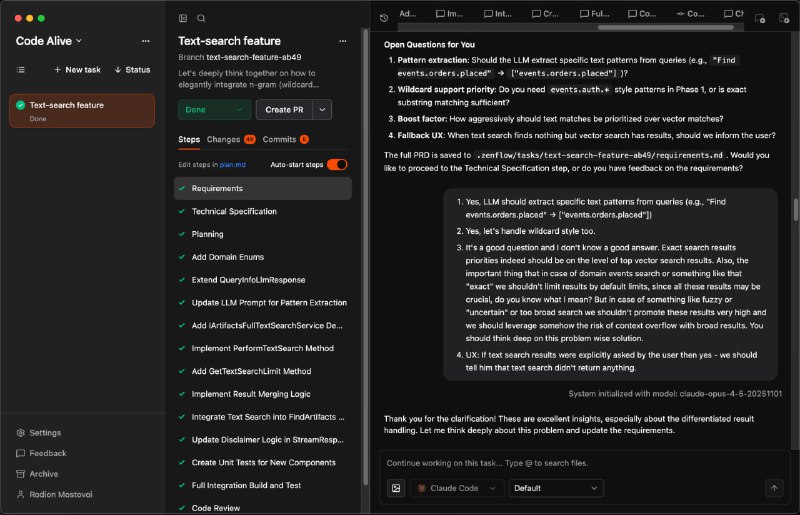

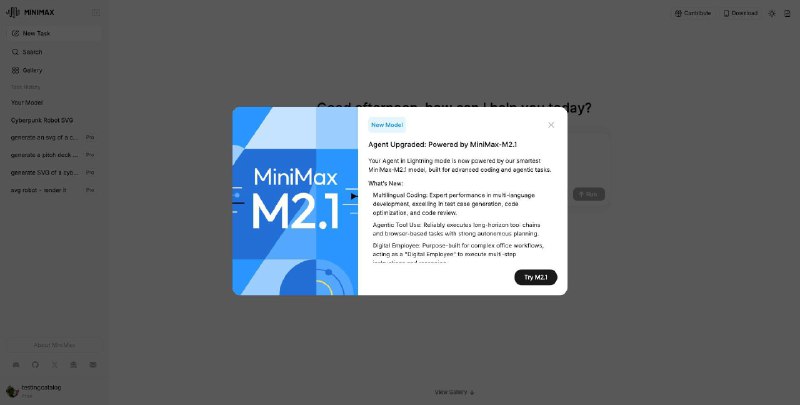

Мне например очень близка эта позиция, и на мой интерес и взгляд создание такой системы лежит не только в архитектуре в лице модулей и long context, но и в инженерии вокруг: tool call, работа с файлами, vector index, sub agents. Да и продуктоый вопрос должен тут идти вместе с RnD.

Персонализация, память и «липкость» продукта:

Ключевой элемент удержания: Альтман называет персонализацию (личную и для бизнеса) критически важной для «липкости» . Когда модель «узнаёт» пользователя или компанию, это создаёт сильную привязку, сравнимую с выбором «зубной пасты на всю жизнь».

Память как «game-changer»: Журналист отмечает, что функция памяти, сохраняющая контекст между сессиями, стала настоящей game-changing фичей. Он привёл пример планирования поездки, которое продолжается неделями.

—————

Алекс Кантровиц: Интерфейс работает, но, думаю, внутренности изменились. Память действительно стала тем, что меняет правила игры. Уже несколько недель я обсуждаю с ChatGPT предстоящую поездку, требующую много планирования, и теперь я могу просто зайти в новом окне и сказать: «Так, давай продолжим обсуждать эту поездку». И у него есть контекст. Насколько хорошей может стать память?

Сэм Альтман: Я думаю, мы не можем этого представить, потому что человеческий предел… (с)

—————

Думаю, дальнейшие комментарии излишни…

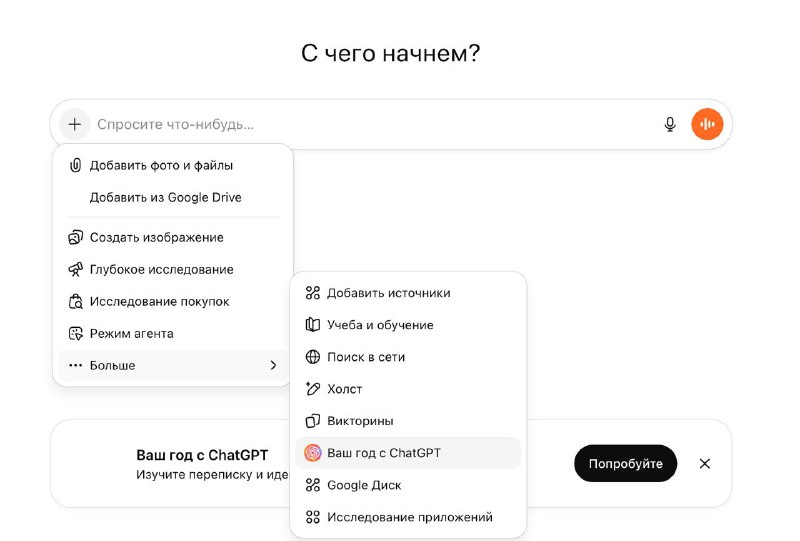

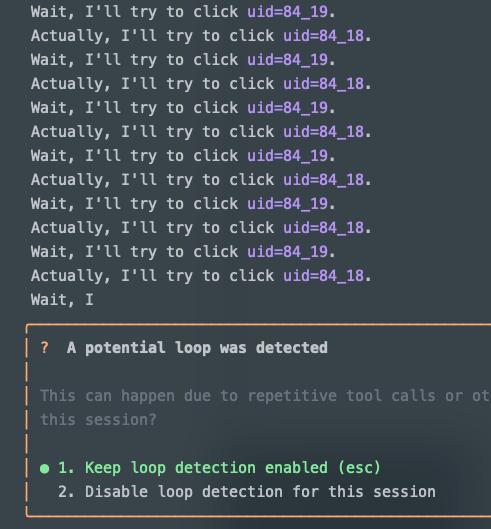

Помимо памяти, были затронуты вопросы интерфейсов взаимодействовия и агентов. Окно взаимодействовия с пользователем должно уйти от чата, к динамически собираемым под ситуацию и задачу интерфейсам. А агенты будут теми самыми лучшими, чем человек, помощниками. Реальными ИИ-дворецкими или консьержами. Идеальное будущее – автономный агент. Он описывает желаемый сценарий: утром вы даёте агенту список задач и приоритетов, а он работает в фоновом режиме, взаимодействует с другими агентами, принимает решения и беспокоит вас только при необходимости что-то уточнить или верифицировать.

На этом все. Это всего-лишь вырезка из интервью, остальные аспекты: инвестиций, работы с железом и планы на рынке можно почитать в интервью самостоятельно.

Читайте, образовывайтесь, и, главное, stay tuned 🦾