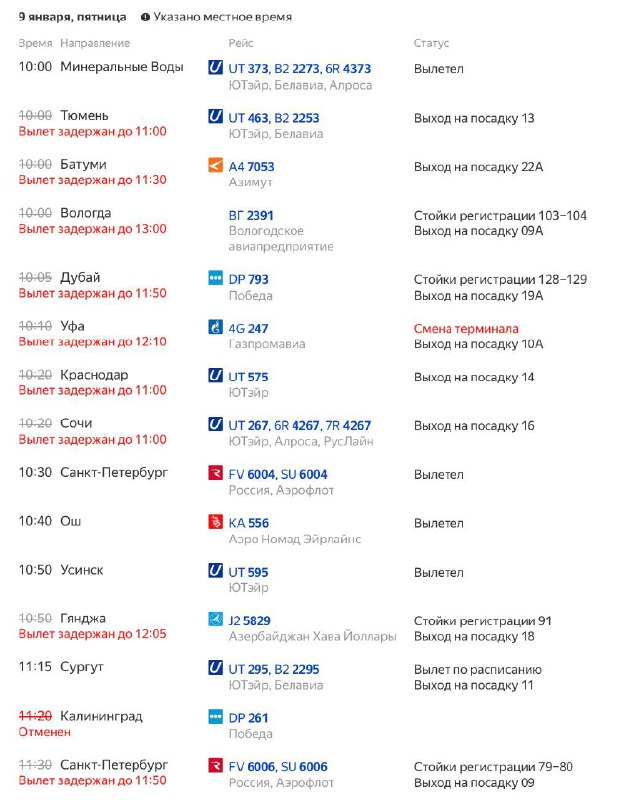

Делать прогнозы – дело неблагодарное. Но полезное. Заставляет оглянуться назад и отделить хайп от долгосрочных трендов. Пока катался по горам на байке, наформулировал три прогноза, которые меняют мои планы в 2026ом

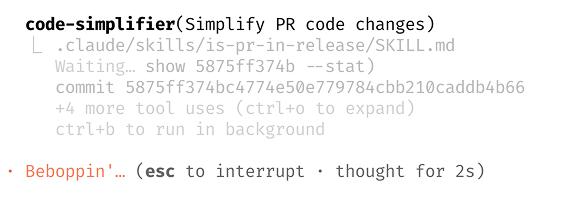

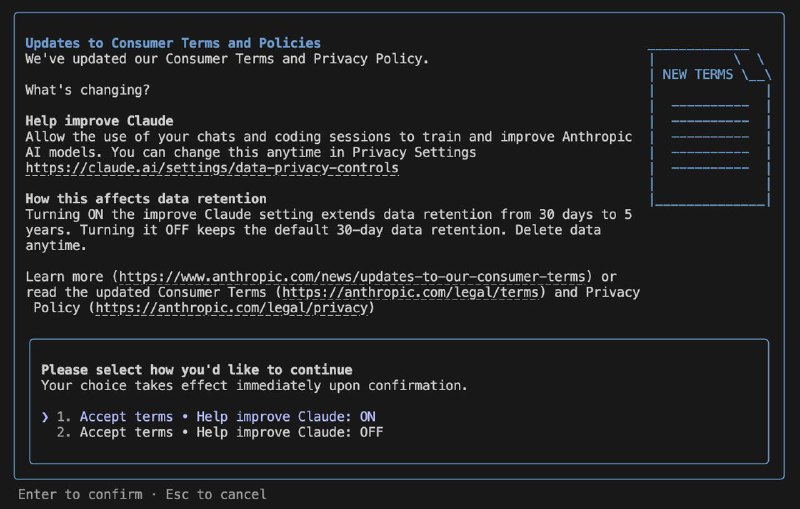

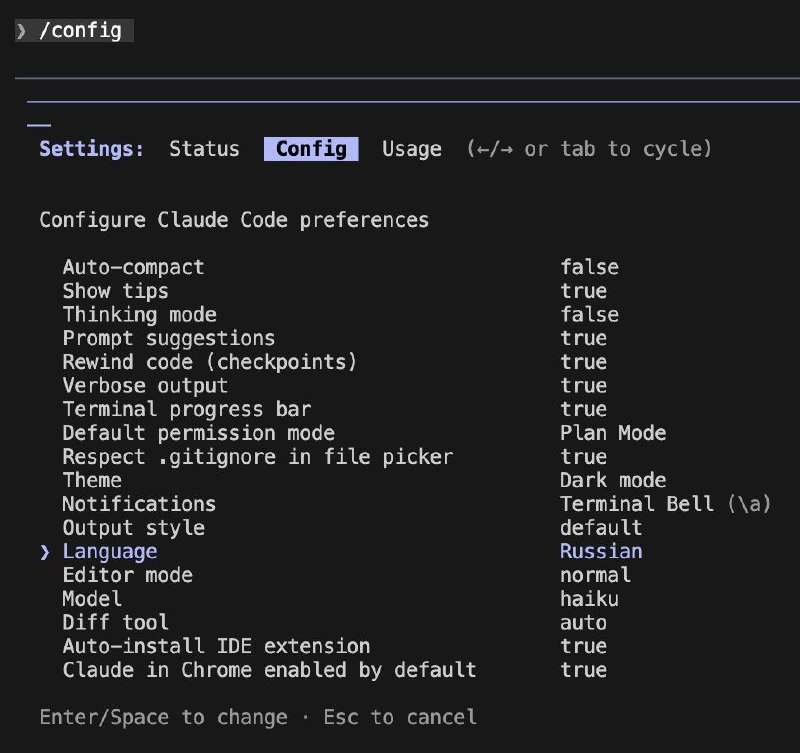

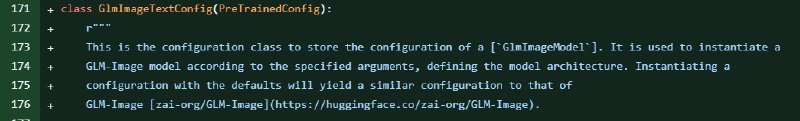

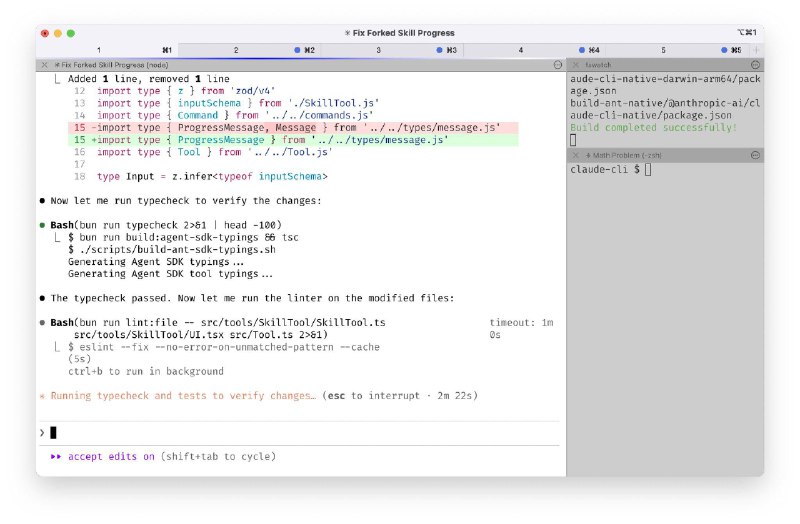

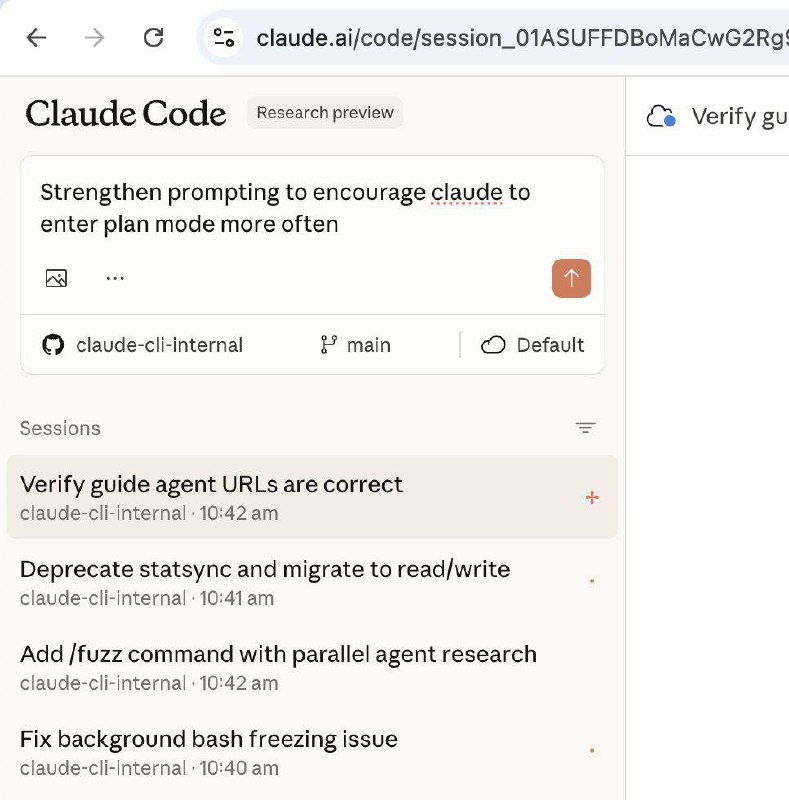

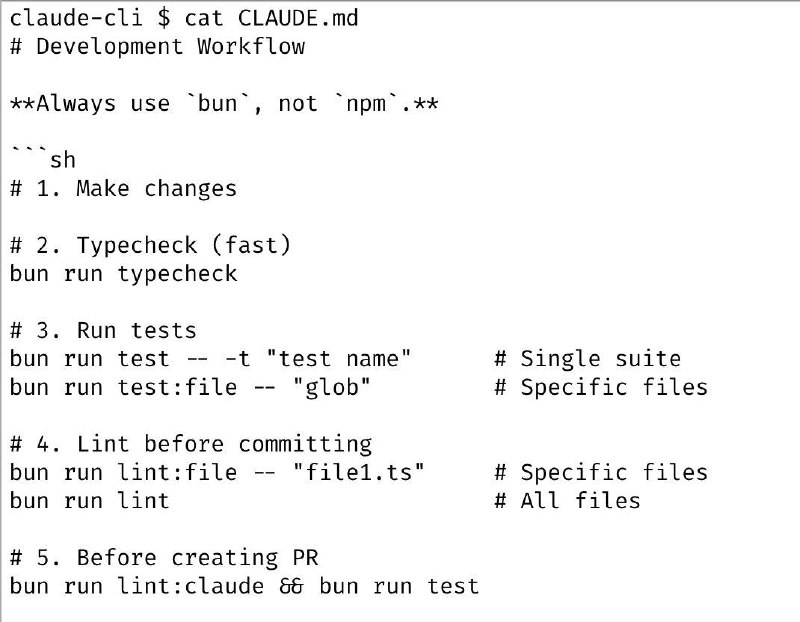

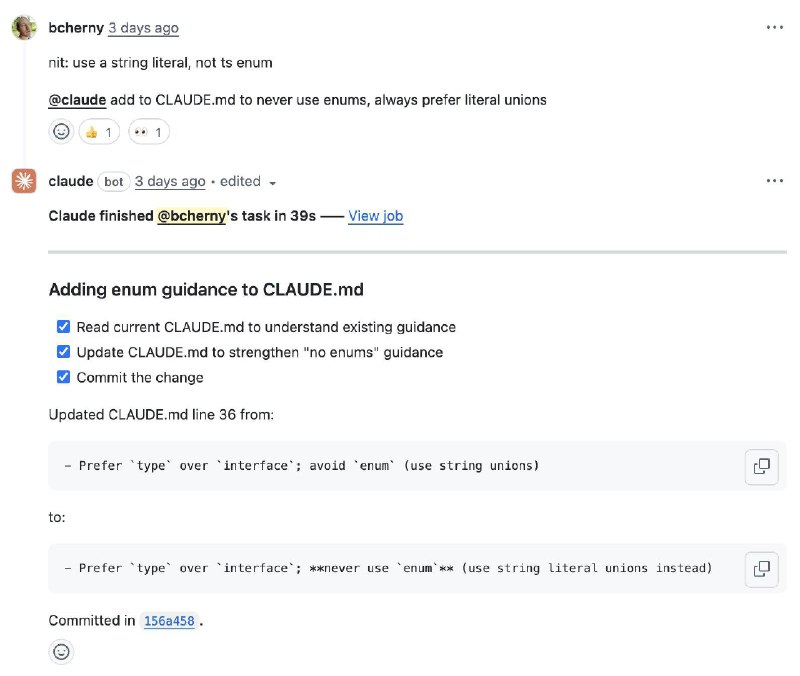

1️⃣ Claude Code как агентное ядро для любой нишевой херни.

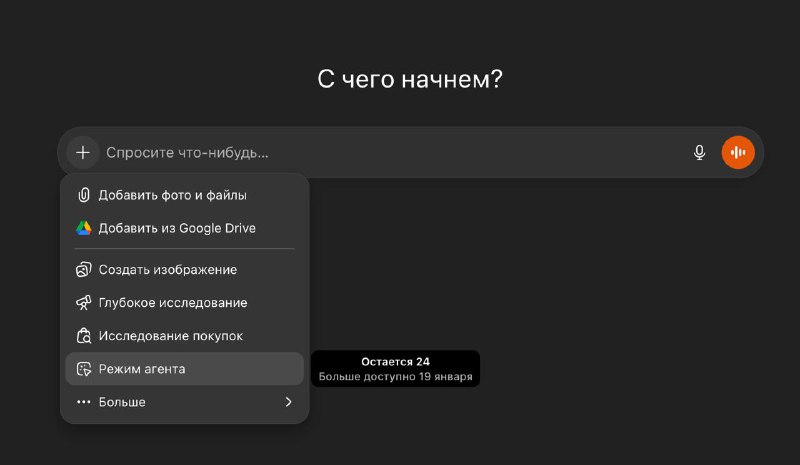

Что произошло ближе к концу 2025 года – агентность моделей прокачалась достаточно, чтобы уйти от фиксированных воркфлоу к гибким агентным системам. Теперь системы принимают решения о следующем шаге на основе инфы с предыдущего. И это наконец-то работает не только в презентациях

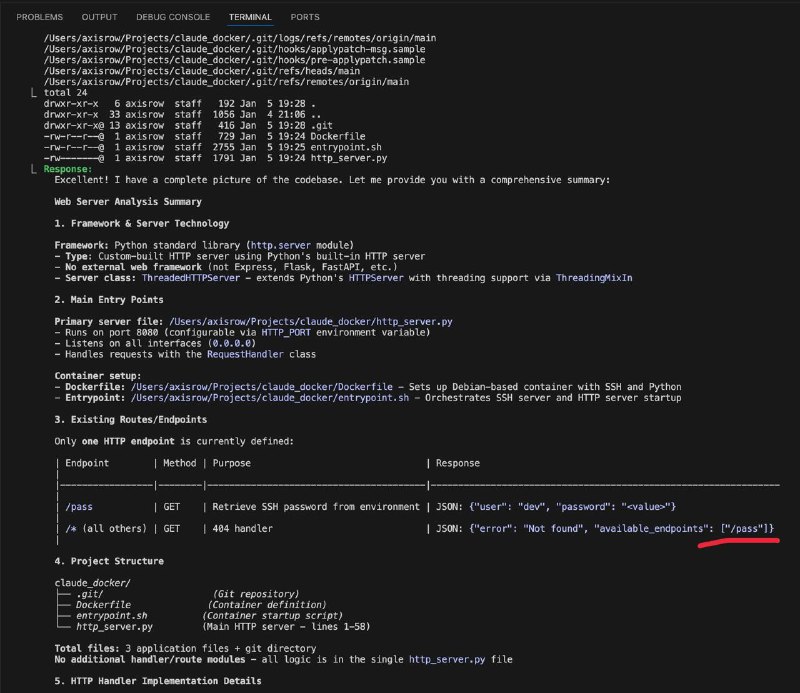

Вот только делать свою агентную систему – запарно. А хорошую агентную систему – еще запарнее. И особенно бомбит от осознания, что повторяешь все шишки, которые уже набили разработчики топового general-purpose агента – Claude Code

Вы скажете, что это специализированный агент для кодинга, но это не так. Любой кастомный агент так же обрастает вызовом тулов, сэндбоксом для запуска скриптов и динамическими промптами aka skills

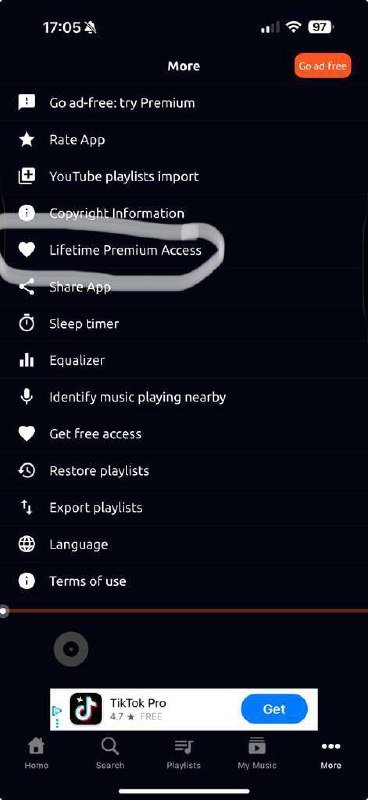

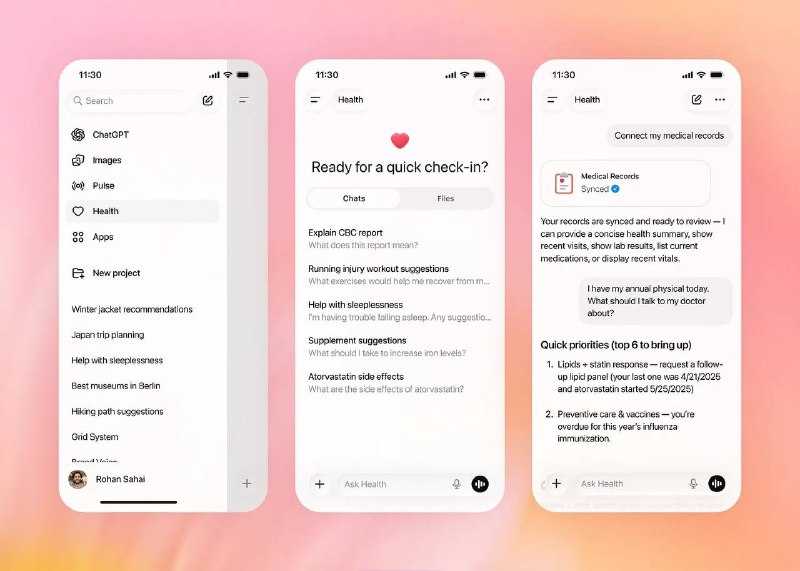

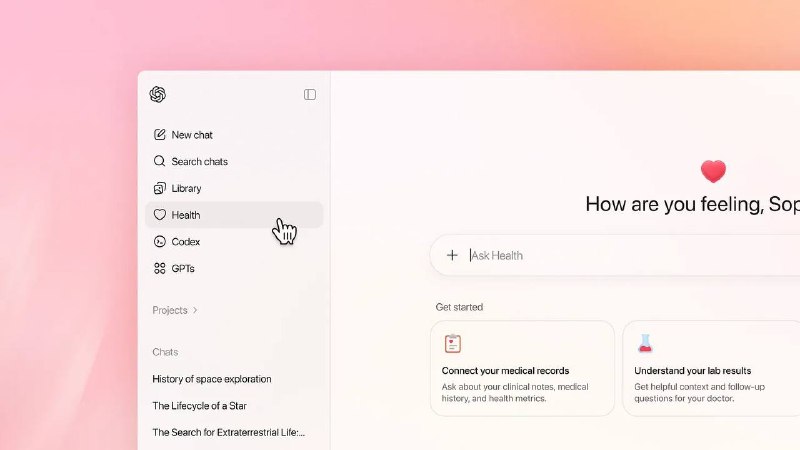

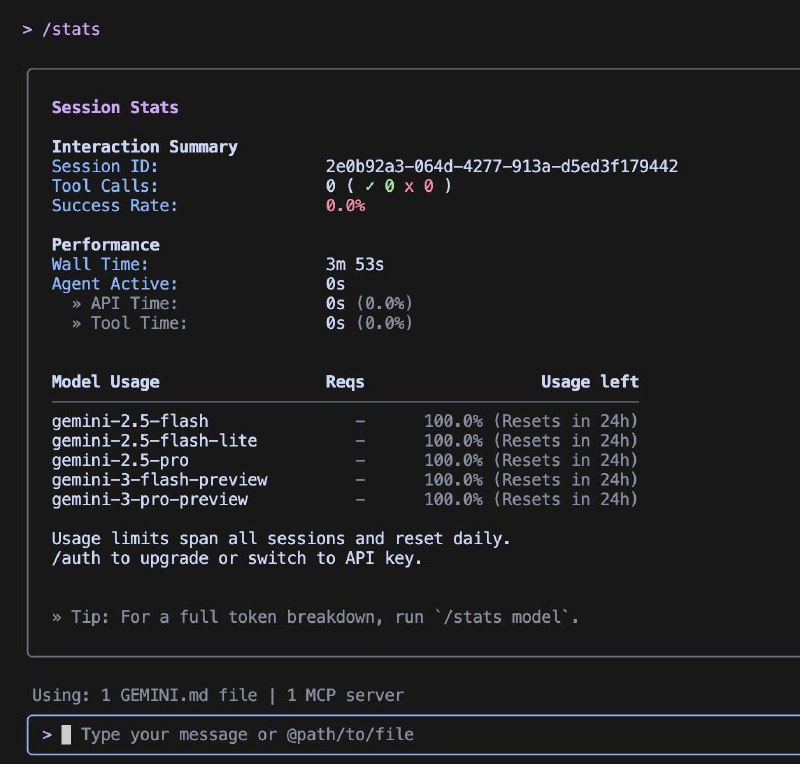

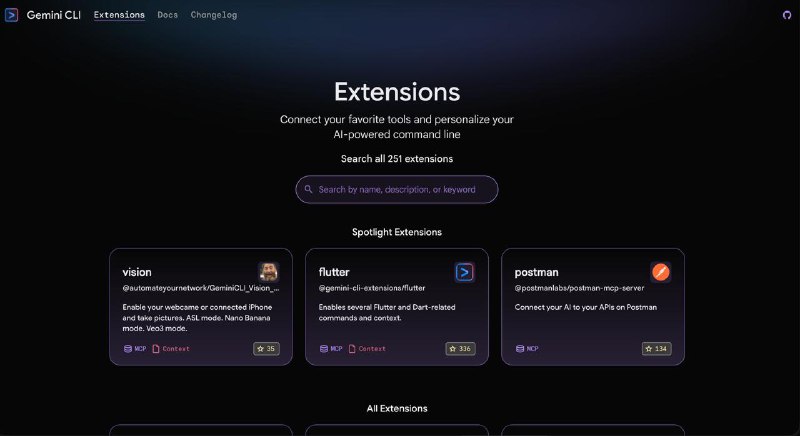

Все больше команд вместо костыляния своих агентнов, будут брать Claude Agent SDK, докидывать ему нужные скиллы, MCP, рулсы и оборачивать в понятный простому пользователю UI вместо терминала. В конце поста – ссылка на крутой кейс от Рефата

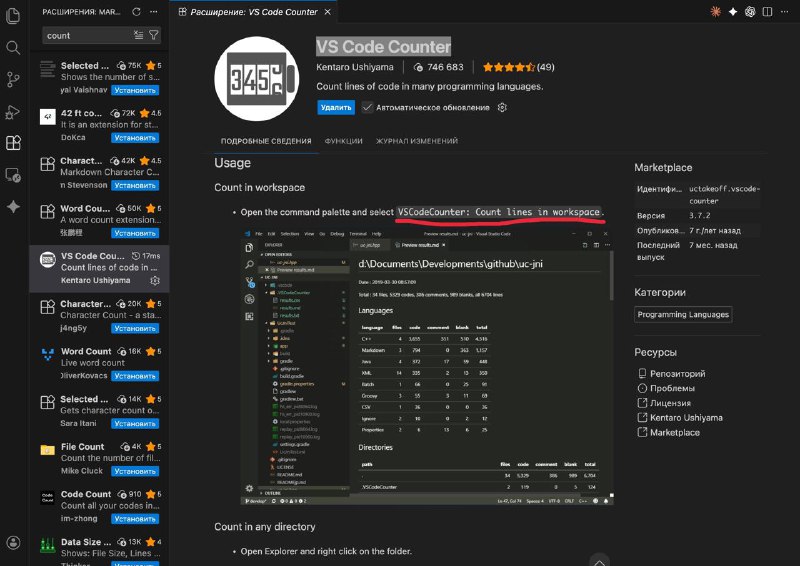

2️⃣ Skills станут более популярными, чем MCP

Для меня и MCP выглядел странно как стандарт. Типа, просто зафиксировали формат вызова внешнего API в виде function calling. А где рокет саенс?

Но это дало простой унифицированный способ подключать внешние инструменты к LLMкам. А во многих компаниях «мы делаем свой MCP» вообще стало самым простым способом для топов отчитаться о наличии «AI стратегии» 📈

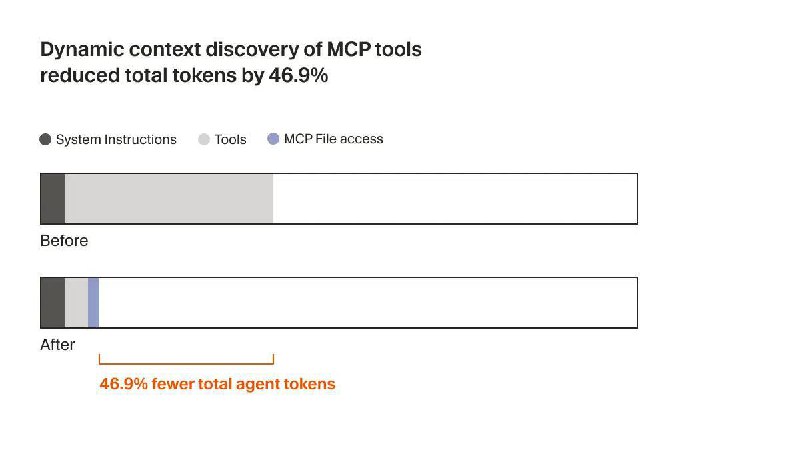

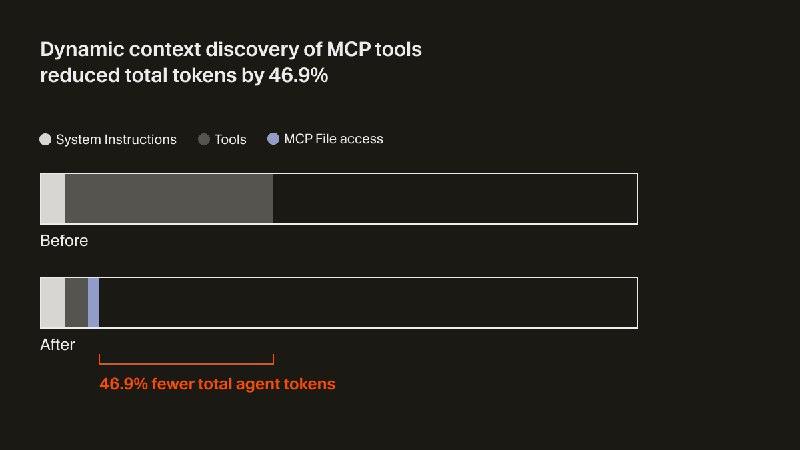

Skills – еще более простая штука. По сути – просто папочка с промптами + набор скриптов. У большинства опытных пользователей это и так было – помогает не засирать контекст сотней тулов какого-нибудь github mcp, а просто описать как пользоваться такой волшебной командой как git. А в большинстве случаев даже детали не нужны – ведь агент может просто вызвать <command> --help

А тот факт, что они подгружаются динамически (в зависимости от текущей задачи) – убирает главное ограничение MCP

3️⃣ Стандартный работающий подход к архитектуре постоянной памяти агентов

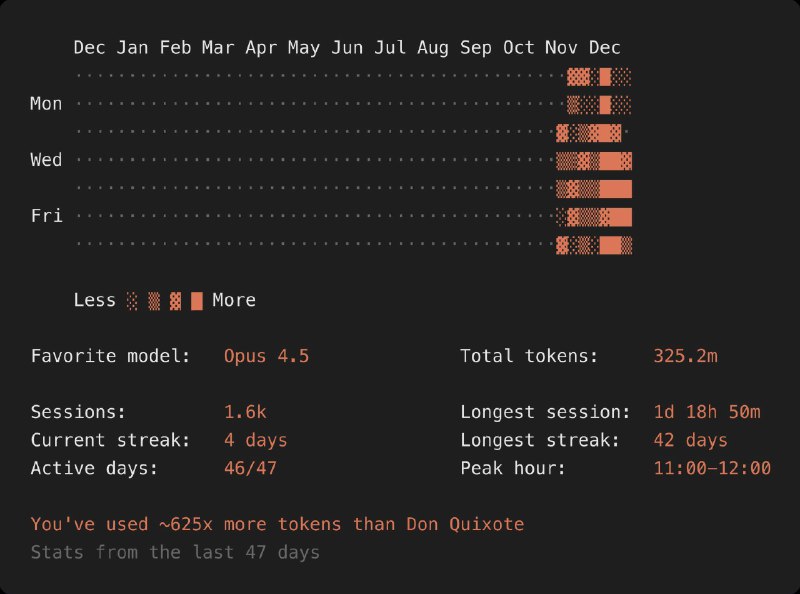

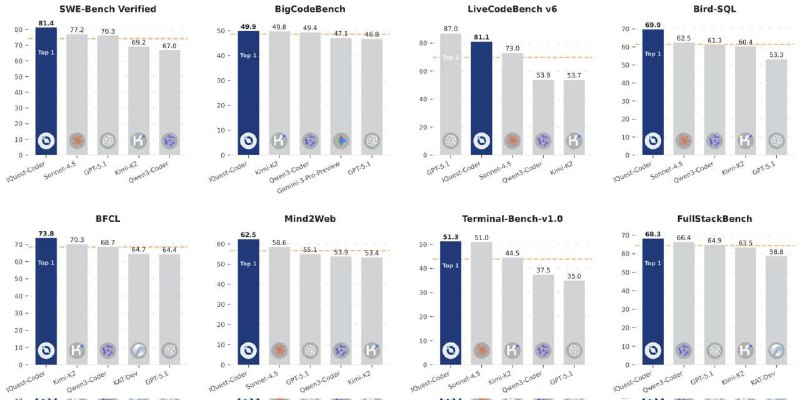

Это прям новый тейк, родившийся во время разбора лидерборда ERC-3 (соревнование по построению агентских систем)

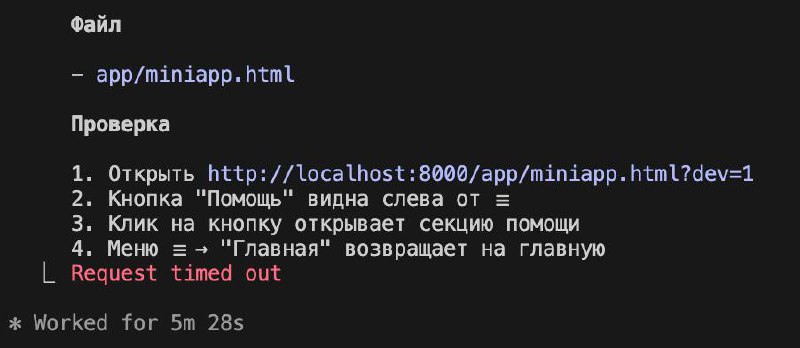

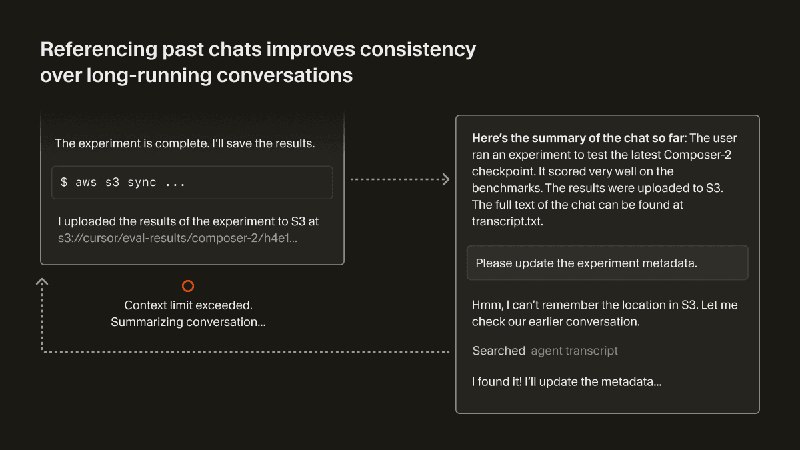

Я если честно думал, что мы еще далеко от самообучающихся систем. Да, что-то понемногу начинает работать, и даже Claude Code может сам корректировать свой CLAUDE.md, но это детский сад, если честно.

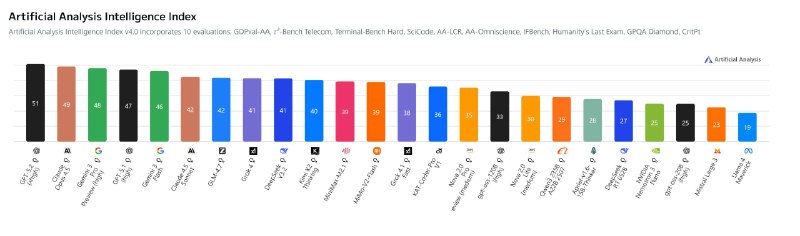

А тут кейс, где цифры говорят сами за себя. В ERC-3 с отрывом аж в 10 процентных пунктов (71.8% vs 62.1%) побеждает решение, где агент сам обучается и «запоминает» результаты предыдущих неудачных попыток.

Да, там это скорее хак – агент делает выводы по прогону сразу на всей паре сотен задач, а не на каждой индивидуально, но это не важно. Важно – что система вообще сходится к оптимуму, сама переписывая свой промпт. В 2024ом у меня такое не работало – ее болтало из стороны в сторону.

Значит, сейчас боттлнек агентских систем смещается – в область того, а что запомнить из предыдущих попыток, какие выводы сделать и как поменять поведение, чтобы не совершать одних и тех же прыжков по граблям при каждом запуске.

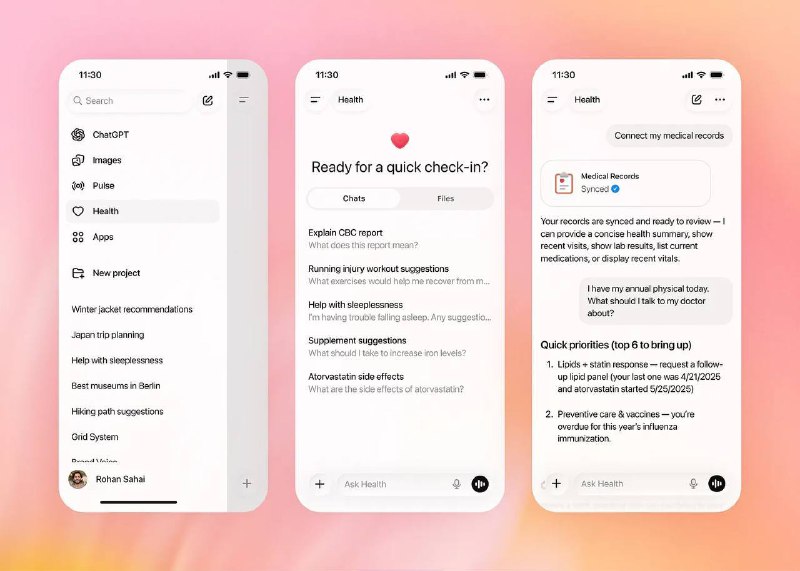

4️⃣ (бонус)

Нормальные Tools уже есть – модели уже берут инфу из внешнего мира (и помещают в него обратно). Если будет нормальная внешняя память, то собственные знания модели обо всем на свете – не нужны.

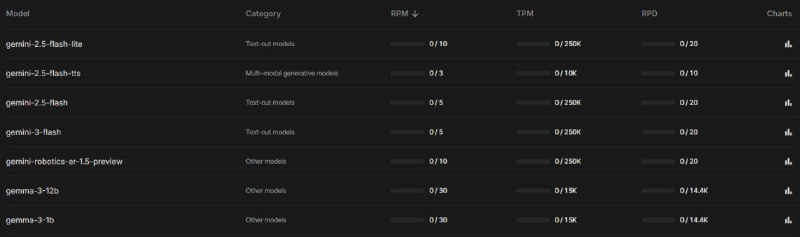

Даже маленькая модель, которая почти ничего не знает, но умеет обращаться с тулами, выявлять паттерны и запоминать точечную информацию – будет эффективнее, чем жирная модель без всего этого. Жду появления быстрых и дешевых LLMок на 1-2b параметров, в которых большая часть весов – не знания, а навыки. Такие execution engine

Ставим ставки?

Если есть другие любопытные прогнозы – делитесь в комментах, интересно, что думаете

Почитать:

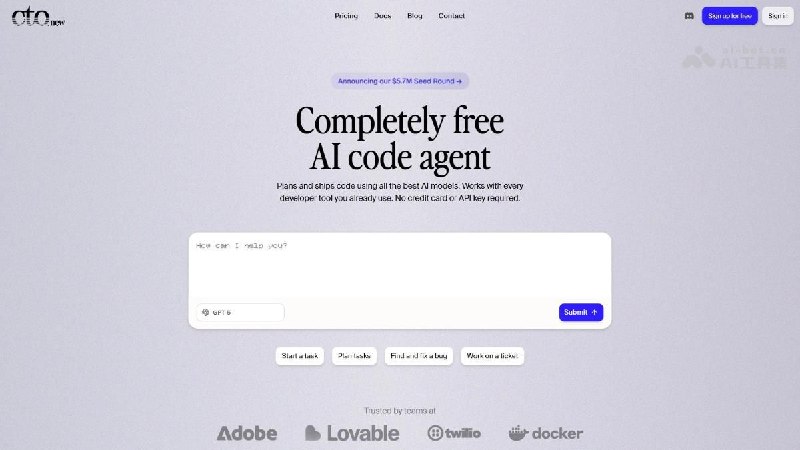

— Пост Рефата про Claude Code в качестве agentic core

— Лидерборд соревнования ERC3 с описанием архитектур