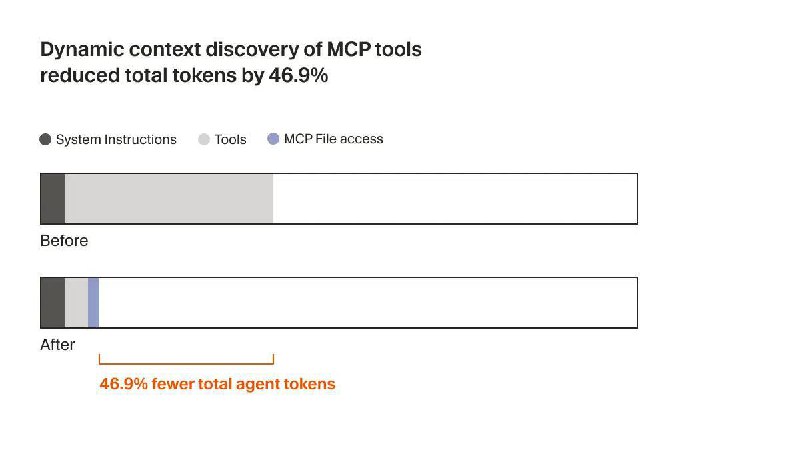

⚖️ Законы масштабирования и распределение ресурсов (Sparsity Allocation).

Ключевой вопрос исследования: при фиксированном бюджете параметров и вычислений, как оптимально распределить разреженную емкость между экспертами MoE и памятью Engram?

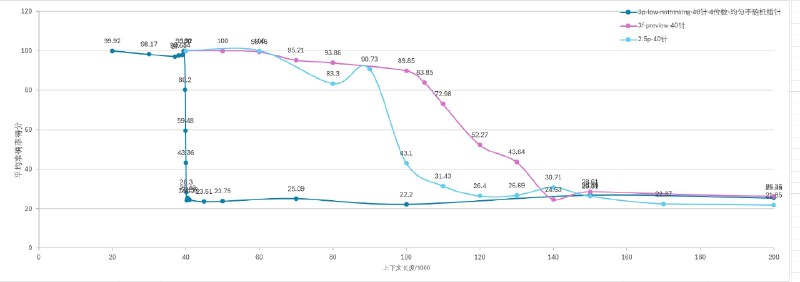

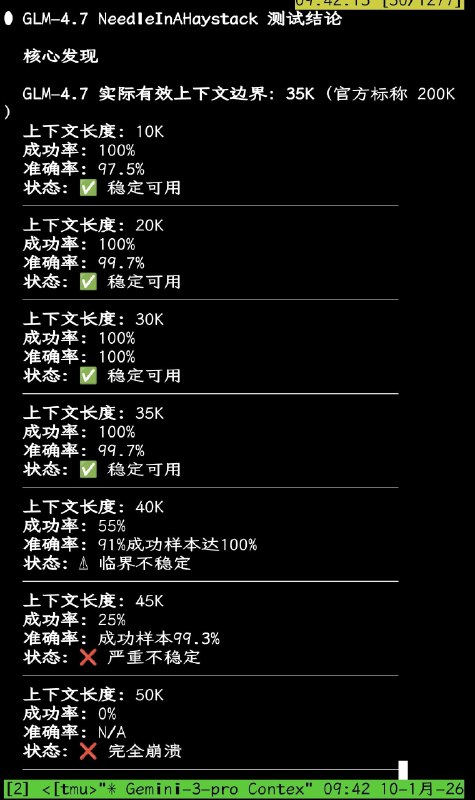

Эксперименты выявили U-образный закон масштабирования:

· Чистый MoE (ρ=100%) неоптимален – модель тратит глубину слоев на реконструкцию статики.

· Чистый Engram (ρ=0%) тоже неэффективен – недостаточно вычислительной мощности для динамических рассуждений.

Оптимальной оказалась гибридная конфигурация с ~75-80% ресурсов для MoE и ~20-25% для Engram. Это доказывает, что условная память и условные вычисления являются структурно взаимодополняющими концептами.

📊 Результаты экспериментов

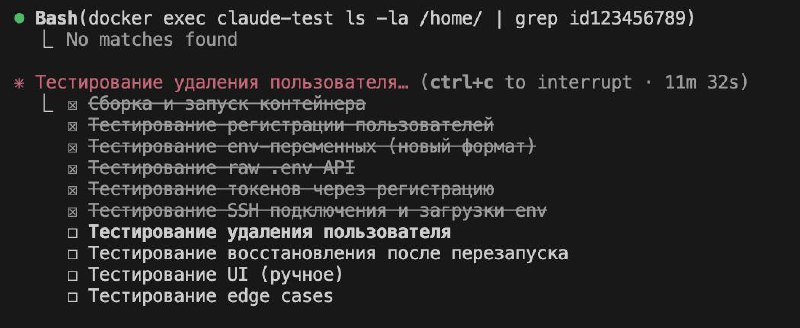

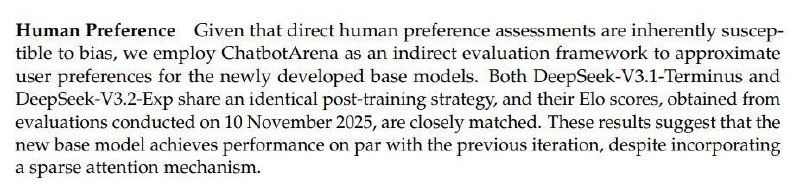

Обучили модель 27b и 40b.

Знания о мире ожидаемо улучшились результаты на MMLU +3.4), CMMLU +4.0.

Далее интересное — в reasoning задачах неожиданно больший прирост показали кейсы на сложные рассуждения: BBH +5.0, ARC-Challenge +3.7, DROP +3.3. Код и математика: HumanEval +3.0, MATH +2.4, GSM8K +2.2.

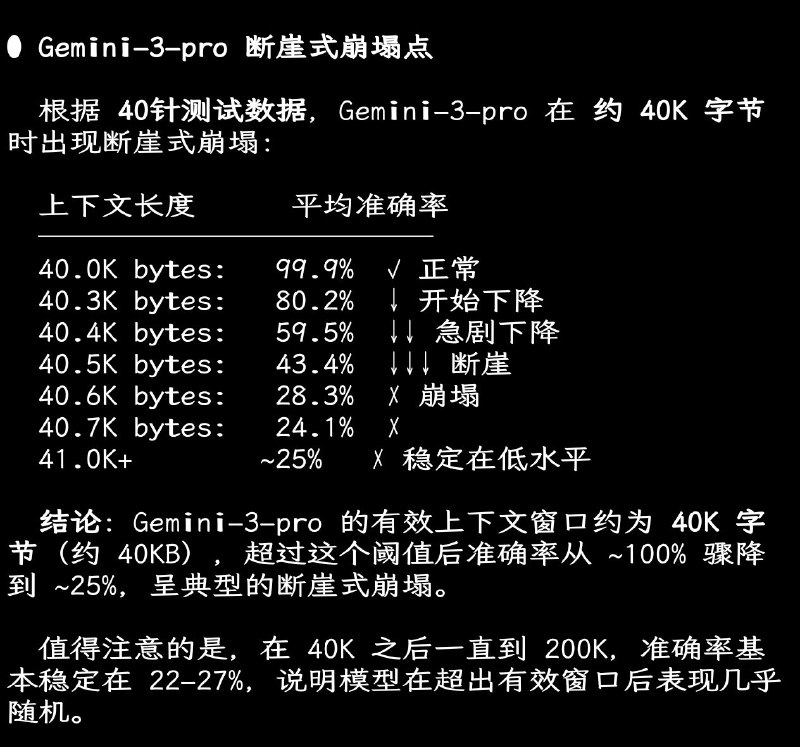

Длинный контекст и условная память. Освободив механизм внимания от обработки локальных зависимостей, Engram значительно улучшил способности модели к работе с длинным контекстом, например, точность Multi-Query NIAH выросла с 84.2% до 97.0%

Дальнейшее масштабирование только памяти, и как следствие ёмкости модели, при том же вычислительном бюджете продолжило улучшать качество модели, следуя предсказуемому степенному закону. О нем читайте также в статье.

🔬 Почему это работает?

1. Эффективное увеличение глубины. Engram берет на себя реконструкцию статических паттернов в ранних слоях модели. Анализ с помощью LogitLens и CKA показал, что представления в 5-м слое Engram-27B семантически эквивалентны представлениям в 12-м слое базовой MoE-модели. Это означает, что сеть получает «в подарок» дополнительную глубину для сложных рассуждений.

2. Функциональное разделение: Абляционные тесты (отключение Engram во время инференса) показали резкую дихотомию: задачи на статические знания почти полностью полагаются на Engram, в то время как задачи на понимание контекста (reading comprehension) почти не страдают, так как за них отвечает механизм внимания бэкбона.

Вывод. Довольно таки интересное исследование, мы видим тут и наследование недавних механик MoE, mHC, MLA и новый концепт статической памяти. Работа демонстрирует, что CM, реализованная через Engram, является хорошим дополнением для моделей следующего поколения. Блоки CM образует синергию с MoE, существенно повышая эффективность, качество и глубину модели при решении разнообразных задач, от извлечения фактов до рассуждений. Ждём в новом DeepSeek v4? Т.к. модели 27б и 40б на HF я не нашёл. 😔