Небольшой ликбез по устройству AI продуктов

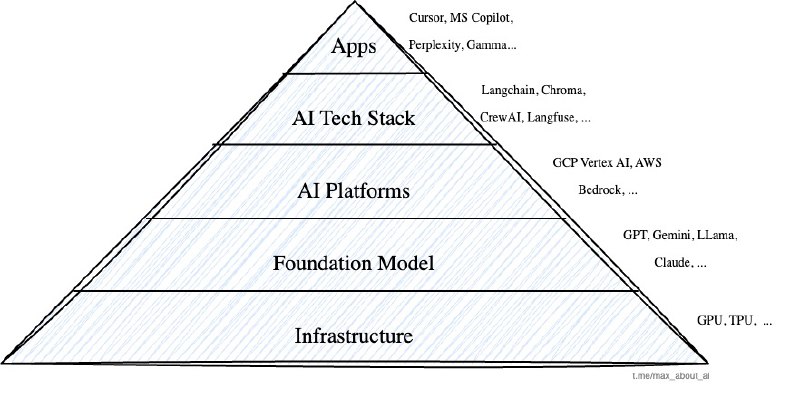

Почти для любого решения, можно выделить как минимум 5 слоев (layers):

➖ Infrastructure: дата-центры, оборудование и вычислительные мощности (GPU, TPU и т.д.)

➖ Foundation models (LLM): большие языковые модели: GPT, Claude, Gemini, LLaMA и другие.

➖ AI Platforms: облачные сервисы, которые позволяют подключать и масштабировать ресурсы, оркестрировать модели, приложения и данные: AWS Bedrock, GCP Vertex AI и т.д.

➖ AI Tech Stack: инструменты для интеграции, мониторинга, оркестрации, хранения данных, файн-тюнинга и пр.: Langchain, Chroma, Langfuse, CrewAI, и многие другие

➖ Applications: конечные продукты для пользователей: MS Copilot, Cursor, Perplexity, Gamma App, и т.д.

Чем ближе к основанию пирамиды, тем более специфические знания и скиллы требуются для работы на этом уровне и тем больше затраты на разработку. Например, стоимость обучения топовых LLM в 2025 году исчисляется миллиардами долларов, а инвестиции в инфраструктуру — сотнями миллиардов.

Большинство компаний занимаются разработкой приложений для конечных пользователей или инструментов (баз данных, фреймворков, сервисов) для разработки конечных приложений.

Добавить комментарий